Nächste Seite: Schätzung der Modellparameter

Aufwärts: Varianzanalyse als lineares Modell

Vorherige Seite: Reparametrisierung der Erwartungswerte

Inhalt

Zweifaktorielle Varianzanalyse

- Beachte

-

- Die Darstellung (15) der Stichprobenvariablen

führt zu der gleichen Art eines linearen Modells,

wie es in Fall 1 von Abschnitt 3.1.2 betrachtet wurde.

führt zu der gleichen Art eines linearen Modells,

wie es in Fall 1 von Abschnitt 3.1.2 betrachtet wurde.

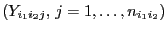

- Die Nummern

bzw.

bzw.

der Klassen

der Klassen

werden erneut als Stufen des jeweiligen Einflussfaktors gedeutet.

werden erneut als Stufen des jeweiligen Einflussfaktors gedeutet.

- Die Designmatrix

hat dabei die Dimension

hat dabei die Dimension

und den vollen Spaltenrang

und den vollen Spaltenrang

.

.

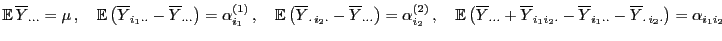

Außerdem betrachten wir eine ähnliche Reparametrisierung der

Erwartungswerte

wie in

Abschnitt 3.1.2.

wie in

Abschnitt 3.1.2.

- Beachte

-

- Die linearen Nebenbedingungen (18) an die

Komponenten des Parametervektors

bewirken, ähnlich wie

bei dem in Abschnitt 3.1.2 betrachteten Modell der

einfaktoriellen Varianzanalyse, dass die Darstellung

(17) - (18) der Erwartungswerte

bewirken, ähnlich wie

bei dem in Abschnitt 3.1.2 betrachteten Modell der

einfaktoriellen Varianzanalyse, dass die Darstellung

(17) - (18) der Erwartungswerte

eindeutig ist.

eindeutig ist.

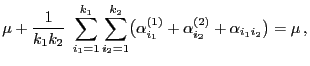

- Dabei kann

als allgemeines Mittel der Erwartungswerte

als allgemeines Mittel der Erwartungswerte

der Stichprobenvariablen

der Stichprobenvariablen

aufgefasst

werden,

aufgefasst

werden,

-

wird Haupteffekt der

wird Haupteffekt der  -ten Stufe

des ersten Einflussfaktors genannt,

-ten Stufe

des ersten Einflussfaktors genannt,

-

heißt Haupteffekt der

heißt Haupteffekt der  -ten Stufe

des zweiten Einflussfaktors, und

-ten Stufe

des zweiten Einflussfaktors, und

-

heißt Wechselwirkung zwischen den Stufen

heißt Wechselwirkung zwischen den Stufen

und

und  der Stufenkombination

der Stufenkombination  .

.

Zur Konstruktion von Schätzern für die Modellparameter  ,

,

,

,

bzw.

bzw.

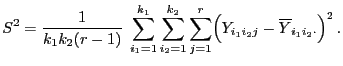

verwenden wir die folgende Notation: Sei

verwenden wir die folgende Notation: Sei

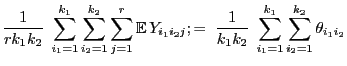

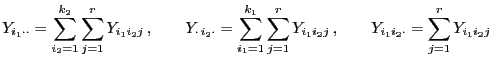

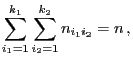

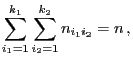

|

(19) |

bzw.

|

(20) |

Theorem 3.3

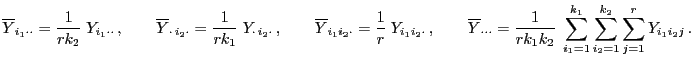

Es gilt

|

(21) |

für beliebige

,

, d.h., durch

,

,

und

sind

erwartungstreue Schätzer für die Modellparameter

,

,

bzw.

gegeben .

- Beweis

Aus der Definitionsgleichung von

Aus der Definitionsgleichung von

in (20) ergibt sich, dass

in (20) ergibt sich, dass

wobei sich die letzte Gleichheit aus den

Reparametrisierungsbedingungen (18) ergibt. Die

anderen drei Teilaussagen in (21) lassen sich auf

analoge Weise beweisen.

- Beachte

-

- Die Bedingungen (18), d.h. die Annahme, dass der

Parametervektor

zu einem linearen Unterraum des

zu einem linearen Unterraum des

gehört, spielen eine wesentliche Rolle im

Beweis von Theorem 3.3.

gehört, spielen eine wesentliche Rolle im

Beweis von Theorem 3.3.

- Dabei können die Aussagen von Theorem 3.3 als

Erwartungstreue der betrachteten Schätzer bezüglich dieses

eingeschränkten Parameterraumes interpretiert werden.

- Wenn jedoch zugelassen wird, dass

ein beliebiger

Vektor der Dimension

ein beliebiger

Vektor der Dimension

ist, dann gibt es keinen KQ-Schätzer für

ist, dann gibt es keinen KQ-Schätzer für

, der gleichzeitig

erwartungstreu ist, vgl. die Diskussion am Ende von

Abschnitt 3.2.1.

, der gleichzeitig

erwartungstreu ist, vgl. die Diskussion am Ende von

Abschnitt 3.2.1.

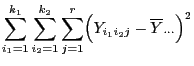

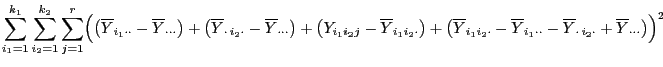

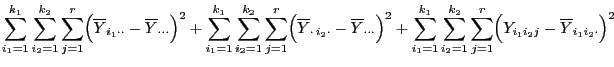

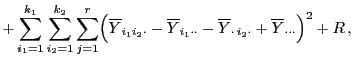

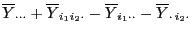

Das folgende Resultat enthält eine Quadratsummenzerlegung,

vgl. auch die Theoreme 2.9 und 3.1.

- Beweis

Mit der in (19) bzw. (20)

eingeführten Notation gilt

Mit der in (19) bzw. (20)

eingeführten Notation gilt

wobei ähnlich wie im Beweis von Theorem 3.1 gezeigt

werden kann, dass die Summe  der gemischten Produkte gleich

Null ist.

der gemischten Produkte gleich

Null ist.

- Beachte

-

Nächste Seite: Schätzung der Modellparameter

Aufwärts: Varianzanalyse als lineares Modell

Vorherige Seite: Reparametrisierung der Erwartungswerte

Inhalt

Hendrik Schmidt

2006-02-27

![]() wie in

Abschnitt 3.1.2.

wie in

Abschnitt 3.1.2.

![]() ,

,

![]() ,

,

![]() bzw.

bzw.

![]() verwenden wir die folgende Notation: Sei

verwenden wir die folgende Notation: Sei